Big Data Analytics Plattform

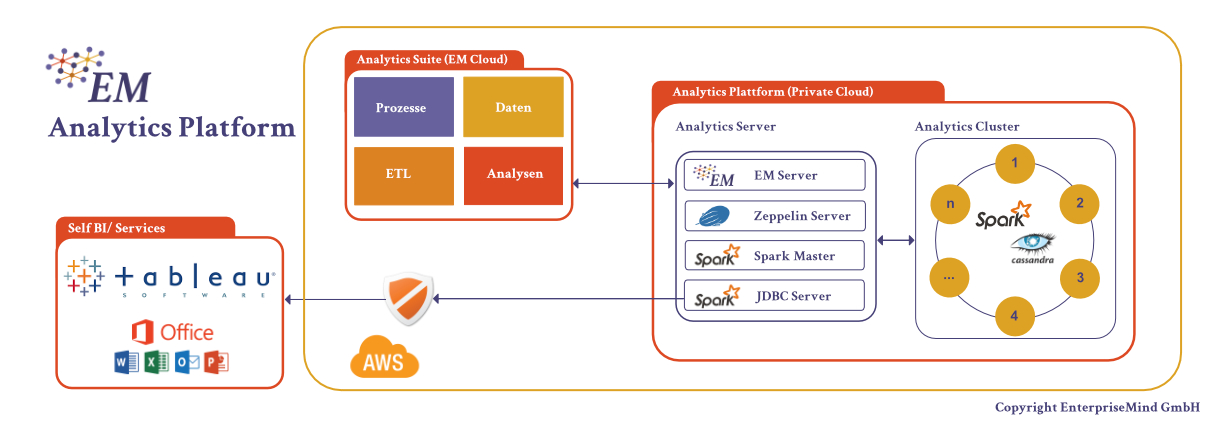

Mit unseren ,,Big Data Analytics“ Plattform bieten wir Ihnen eine technische Lösung, mit deren Hilfe Sie Ihre kostbaren Daten sicher aufbewahren, zuverlässig verarbeiten und schnell analysieren können. Unsere Analytics Suite mit den Modulen Prozessmanagement, Datenmanagement, ETL und Analytics & Reporting unterstützt Sie dabei, ist aber für den Betrieb der Plattform nicht notwendig.

Unser Plattform haben wir auf dem Industriestandard Java aufgebaut und führenden Technologien, wie Cassandra und Spark, integriert. Diese sind aufeinander bestens abgestimmt und bieten Ihnen Support und Entwicklungssicherheit.

Da wir die Plattform in Ihrer ,,Private Cloud“ implementieren, haben Sie die vollständige Kontrolle über Ihre Daten und hohe Flexibilität über Ihre Prozesse. Dennoch nutzen Sie die Vorteile einer Cloud-basierten Lösung wie geringe Investitionskosten, hohe Skalierbarkeit, maximale Mobilität und verbrauchsbasierten Gebühren.

Komponenten

Cassandra ist eine der führenden verteilten und hochverfügbaren No-SQL Datenbanken, die bei namhaften Unternehmen u.a. Cisco, Credit Suisse, Disney, Ebay, Hp uvm. im Betrieb ist.

Cassandra ist bekannt für Hochverfügbarkeit und Hochdurchsatz -Eigenschaften und sie ist in der Lage, enorme Schreiblasten zu handhaben und Cluster-Knoten Ausfälle zu überstehen. In Bezug auf das CAP-Theorem bietet Cassandra eine konfigurierbare Konsistenz und Verfügbarkeit für den Betrieb.

Im Hinblick auf die Datenverarbeitung ist Cassandra linear skalierbar (erhöhte Belastungen können durch Erhöhung der Anzahl der Knoten eines Clusters abgedeckt werden) und sie ist in der Lage, Cross-Rechenzentrum Replikation (XDCR) durchzuführen. XDCR bietet eine Reihe von interessanten Anwendungsfälle für:

- geo-verteilte Rechenzentren: Daten, die spezifisch für die Region sind oder näher an den Kunden liegen.

- Datenmigration in Rechenzentren: Wiederherstellung nach Ausfällen oder Verschieben von Daten auf einen neuen Datacenter.

- getrennte Betriebs- und Analytik-Workloads: Es können getrennte Cluster für schreib-intensive und analyse-intensive Anwendungen aufgesetzt werden.

Cassandra unterliegt der Apache 2.0 Lizenz.

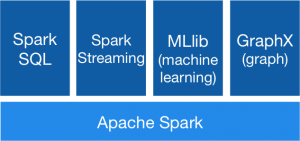

Spark ist eine sehr schnelle Engine für verteilte, groß angelegte Datenverarbeitung und wird heute als quasi Standard in den meisten Plattformen (SAP, Microsoft, IBM usw.) für Big-Data Analytics verwendet.

Dabei wird nach dem „Map-Reduce“ Prinzip die Datenverarbeitungsaufgabe vom Spark-Master in mehrere Teile zerlegt und an die verteilten Maschinen (sog. Worker) verschickt. Diese arbeiten die Teilaufgaben ab und senden die Ergebnisse an den Master, der die Teilergebnisse zu einem Gesamtergebnis zusammenfügt. Ein Spark-Cluster kann dabei aus einer Vielzahl (Je nach Anforderungen) von verteilten Maschinen (sog. Worker) bestehen

Spark hat die führende Technologie der letzten Jahren ,,Hadoop MapReduce“ abgelöst und führt die Programme bis zu 100x schneller als ,Hadoop MapReduce im Speicher (In Memory) oder 10x schneller auf dem Datenträger aus. Darüber hinaus ist die Handhabung einfacher, die Programmierung effizienter und die Module für verschiedene Analytics-Aufgaben sind bereits in Spark integriert.

Spark unteliegt der Apache 2.0 linzenz.

Zeppelin ist ein web-basierter Notebook, das interaktive Datenanalysen ermöglicht. Mit den Notebooks von Zeppelin kann man folgende Aufgaben durchführen:

- Data Ingestion

- Data Discovery

- Data Analytics

- Data Visualization & Collaboration

Zeppelin Interpreter-Konzept ermöglicht, dass eine Vielzahl von Daten-Verarbeitung-Backend integriert werden können. Besonders ausgezeichnet ist die Integration von Spark und Cassandra. Darüber hinaus unterstützt Zeppelin viele Interpreter wie Java, Scala, Python, R JDBC und Shell.

Cassandra unterliegt der Apache 2.0 Lizenz.

Mit dem EnterpriseMind-Connector wird die Verbindung zwischen Ihrer ,,Big Data Analytics“ Plattform und der Analytics-Suite hergestellt. Es unterstützt folgende Funktionen:

- Erzeugen von Tabellen gemäß den Schemas aus dem Modul Datenmanagement

- Erfassen und Abfragen von Daten

- Durchführen von ETL-Jobs

- Überwachung der Abarbeitung von ETL Jobs

Der EM-Connector dient als Schnittstelle. Es werden keine Daten aus der EM-Plattform in der Analytics Suite gespeichert. Datenanalysen werden direkt vom Zeppelin-Server durchgeführt.

Big Data Analytics

Big Data wird mit den drei folgenden Merkmalen charakterisiert.

- Volume: Es werden große Datenmengen generiert

- Variety: Es handelt sich um verschiedene Datentypen und Datenquellen

- Velocity: Die Daten werden mit hoher Geschwindigkeit generiert und verarbeitet

Durch die Big Data Lösungen können neue Erkenntnisse gewonnen werden, insbesondere in Bereichen, in denen zwar viele Daten generiert, aber die Potentiale noch nicht genutzt wurden. Unternehmen können durch die Analyse von Big Data Wettbewerbsvorteile erlangen, Einsparungspotentiale generieren und neue Geschäftsfelder schaffen. Beispiele für Big Data Anwendung sind u.a.

- Fraud-Detection: Entdeckung von Unregelmäßigkeiten bei Geschäftsvorfällen und Transkation

- Smart Metering: Ermöglicht intelligente Netz- und Ressourcensteuerung

- Smart Billing: Aufbau flexibler Abrechungssystemen

- Predective Mainatance : Reduzierung Ausfallzeiten von Maschienen und Geräten

Die technische Entwicklung der Prozessor Leistung kann jedoch mit der Menge der zu verarbeitenden Daten nicht Schritt halten. Mit den Anforderungen an Geschwindigkeit begann seit Anfang 2000 der Erfolg der No-SQL Datenbanken als verteilte Systeme. Dabei werden von der Datenbank mehrere Kopien erstellt und diese auf mehrere Systeme verteilt. Die Datenbanken können dann parallel abgefragt werden, was den Durchsatz erhöht. Der Nachteil dieser Systeme liegt in sogenanten CAP Theorem, der besagt, dass nur zwei Ziele gleichzeitig erreicht werden können.

- Konsistenz (C consistency): Die Konsistenz der gespeicherten Daten. In verteilten Systemen mit replizierten Daten muss sichergestellt sein, dass nach Abschluss einer Transaktion auch alle Replikate des manipulierten Datensatzes aktualisiert werden.

- Verfügbarkeit (A availability): Die Verfügbarkeit im Sinne akzeptabler Antwortzeiten. Alle Anfragen an das System werden stets beantwortet.

- Ausfalltoleranz (P partition tolerance): Die Ausfalltoleranz der Rechner-/Servernetze. Das System arbeitet auch bei Verlust von Nachrichten, einzelner Netzknoten oder Partition des Netzes weiter.

Der Fokus von Cassandra im Bereich Analytics liegt auf Verfügbarkeit und Ausfalltoleranz, wobei Konsistenz zu Lasten der zwei anderen Ziele verbessert werden kann.

Der zweite Nachteil liegt in der beschränkten Abfragemöglickheit. Im Gegensatz zu SQL-Datenbanken muss bereits beim Tabellendesign festgelegt werden, wie die Daten abgefragt werden sollen. Ansonsten bedarf es einer Analytics Engine wie Spark, die die Daten auswerten und analysieren kann. Erst durch eine Analytics Engine kann auch der Mehrwert von Big-Data durch Advanced Analytics generiert werden.

Unsere ,,Big Data Analytics“ Plattform ist auf die Anforderungen von Big Data ausgelegt und stellt sicher dass Ihre Daten sicher, hoch verfügbar und gemäß Ihren Geschäftsanforderungen analysiert werden können. Mit Spark und Cassandra bauen wir auf Technologien, die sich in vielen anspruchsvollen Big-Data-Anwendungen bereits bewährt haben.